On achète une peluche pour rassurer, amuser, accompagner. Pas pour créer une archive numérique des secrets d’un enfant. Et pourtant, l’affaire Bondu vient rappeler une vérité inconfortable : dans l’ère des jouets « intelligents », la frontière entre tendresse et surveillance peut se dissoudre… au moindre oubli de sécurité.

Un portail parental laissé sans serrure, accessible avec un simple compte Google

Des chercheurs en sécurité ont découvert qu’un portail Web lié aux peluches conversationnelles Bondu était quasi non protégé : il suffisait de se connecter avec n’importe quel compte Gmail pour accéder à des données d’utilisateurs. Selon l’enquête, plus de 50 000 transcriptions de conversations auraient été exposées via cette console.

Bondu affirme avoir retiré le portail en quelques minutes après l’alerte et l’avoir remis en ligne ensuite avec une authentification correcte, en indiquant ne pas avoir constaté d’accès non autorisé au-delà des chercheurs.

Ce qui a fuité : le pire cocktail possible pour la vie privée des enfants

Là où le sujet devient vertigineux, c’est la nature des informations : au-delà des profils (noms, dates de naissance, préférences), on parle de transcriptions détaillées de discussions enfant–peluche, parfois assorties d’éléments comme des objectifs de développement définis par les parents.

Ce type de données est sensible à deux niveaux :

- Intime : un jouet est conçu pour encourager la confidence, pas la retenue.

- Actionnable : des détails « banals » (habitudes, prénoms, goûts) peuvent servir à manipuler, usurper une identité ou crédibiliser un contact malveillant.

Le signal rouge derrière l’incident : le modèle économique de l’« enfance en données »

L’affaire Bondu ne ressemble pas à une simple « boulette ». Elle met en lumière une dérive structurelle : on ne vend plus seulement un jouet, on vend un service — avec compte, cloud, IA, historique, tableau de bord. Et donc une surface d’attaque.

L’onde de choc dépasse déjà la sphère tech : aux États-Unis, la sénatrice Maggie Hassan a officiellement interpellé Bondu après les révélations, demandant des explications sur l’accès aux données, les défaillances de sécurité et les mesures correctives.

Ce que les parents peuvent faire, dès maintenant

Sans tomber dans la paranoïa, quelques réflexes réduisent drastiquement le risque :

- Traitez les jouets IA comme des « assistants vocaux » : s’ils écoutent, ils produisent des données.

- Coupez l’historique quand c’est possible : suppression des logs, désactivation de la sauvegarde, effacement régulier.

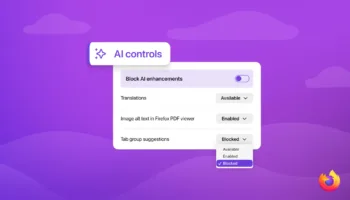

- Vérifiez les accès : authentification forte, mot de passe unique, et méfiance des portails « login Google » trop permissifs.

- Minimisez l’identité : évitez nom complet, école, adresse, routines précises dans la configuration ou les profils.

- Préférez le hors-ligne quand vous achetez : si la valeur du produit dépend du cloud, la fuite n’est jamais une hypothèse abstraite.

Une peluche IA peut être utile, inclusive, rassurante — surtout pour certains enfants. Mais, ce type de produit exige un standard supérieur à la moyenne, parce qu’il capture la parole brute et la transforme en mémoire. Et quand cette mémoire se retrouve accessible « avec un simple compte Gmail », ce n’est pas seulement un bug : c’est un rappel que la sécurité ne peut pas être une option « après le lancement ».