Google vient de publier une mise à jour majeure de Gemini 3 Deep Think, son mode de raisonnement le plus spécialisé, pensé pour les problèmes qui résistent aux approches « chatbot » classiques : données incomplètes, contraintes floues, multiples solutions plausibles — bref, la vraie vie des labos et des équipes d’ingénierie.

Ce qui change avec cette version, c’est autant la promesse (un outil plus utile dans des workflows scientifiques concrets) que la stratégie de distribution : Deep Think est désormais accessible dans l’app Gemini pour les abonnés Google AI Ultra, et, pour la première fois, arrive dans le Gemini API via un programme d’accès anticipé.

Une IA conçue pour les problèmes « sales »

Google insiste : Deep Think a été « raffiné » en collaboration avec des scientifiques et des chercheurs pour traiter des défis où il n’y a pas de garde-fous clairs ni de réponse unique, et où les données sont « messy » ou incomplètes. L’idée est de combiner connaissance scientifique et utilité d’ingénierie pour produire des sorties actionnables.

Et pour rendre ça tangible, Google met en avant trois cas d’usage d’early testers :

- Relecture mathématique : la mathématicienne Lisa Carbone (Rutgers) a utilisé Deep Think pour relire un papier très technique ; le modèle aurait détecté une faille logique subtile passée sous le radar de la relecture humaine.

- Science des matériaux : le Wang Lab (Duke) l’aurait utilisé pour optimiser des méthodes de croissance cristalline, avec une « recette » permettant d’obtenir des films fin > 100 μm.

- Design industriel/composants : Anupam Pathak (Google Platforms & Devices) l’aurait testé pour accélérer la conception de composants physiques.

Des scores qui servent de vitrine : math, code… et olympiades

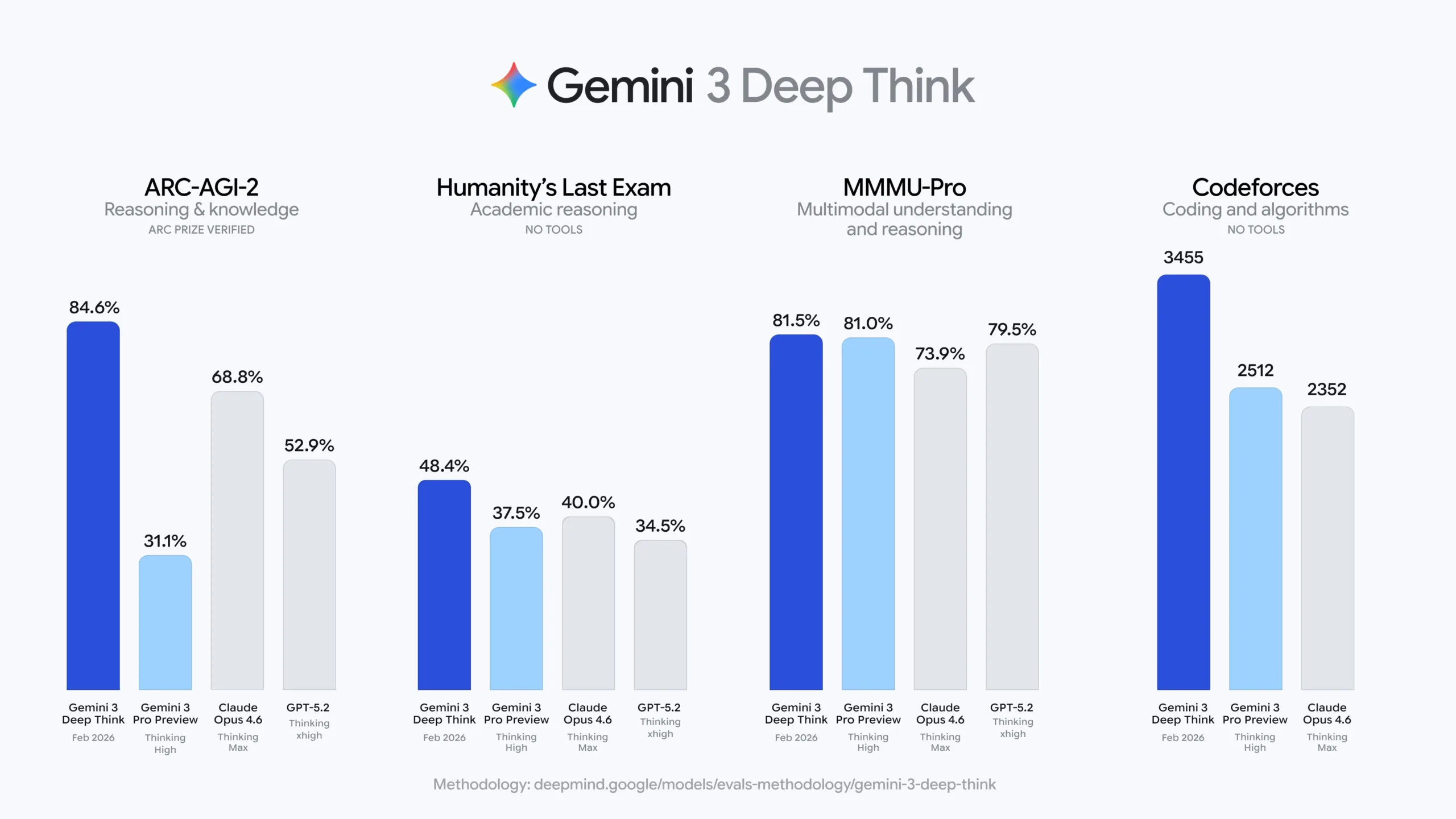

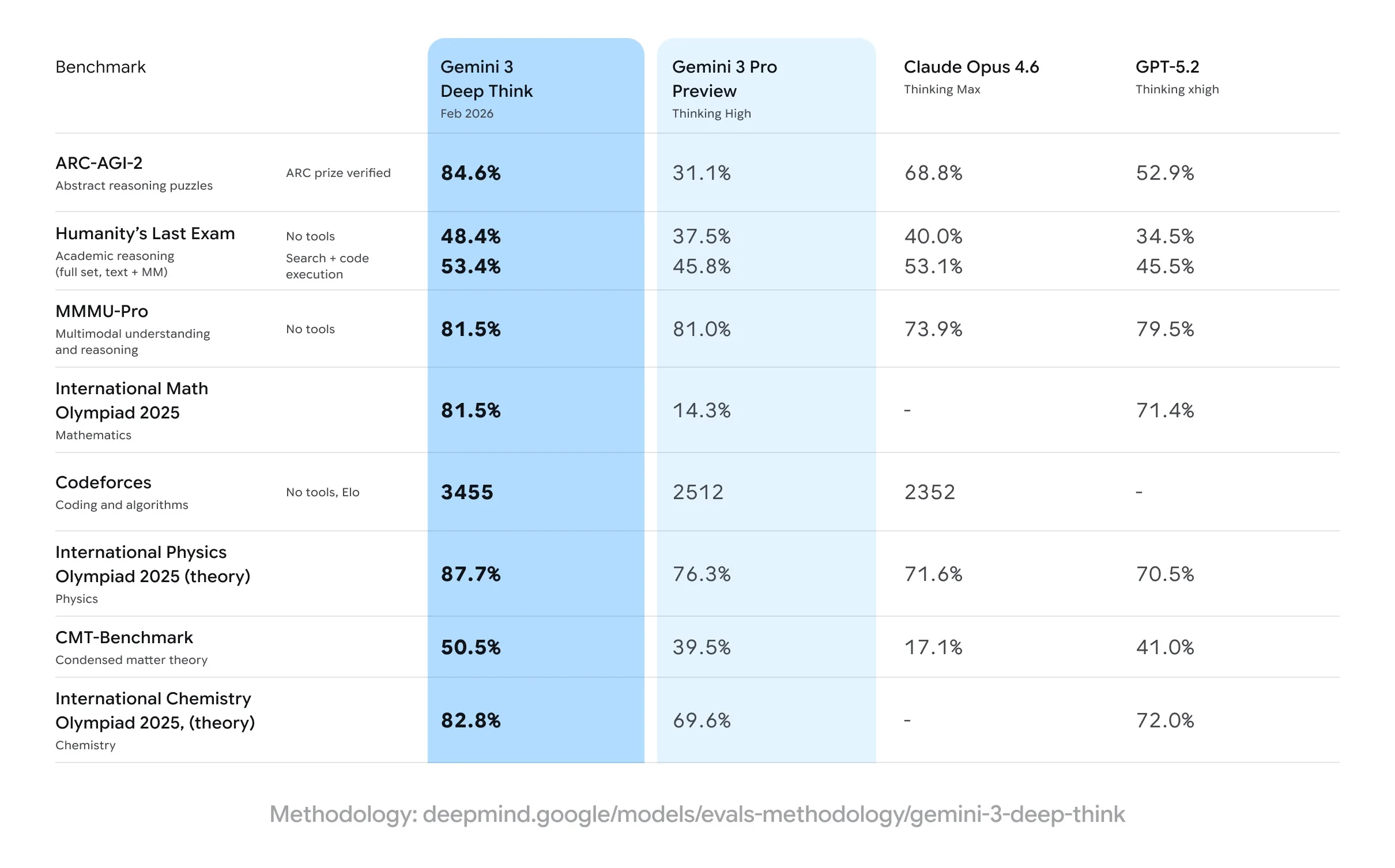

Google replace aussi Deep Think dans la course aux benchmarks « durs » — ceux qui sont censés mesurer une forme de raisonnement robuste :

- Humanity’s Last Exam : 48,4 % (sans outils)

- ARC-AGI-2 : 84,6 % (score indiqué comme vérifié par l’ARC Prize Foundation)

- Codeforces : Elo 3455

- International Math Olympiad 2025 : performance « niveau médaille d’or »

L’article précise que le modèle progresse aussi sur des domaines scientifiques : résultats « niveau médaille d’or » sur les parties écrites des Olympiades internationales 2025 de physique et chimie, et 50,5 % sur le CMT-Benchmark en physique théorique avancée.

Derrière « Deep Think », une idée plus large : l’agent de recherche

Le point le plus intéressant — et le plus « DeepMind » — est peut-être ailleurs : Google décrit comment Deep Think alimente déjà des approches agentiques en mathématiques, dont un agent interne baptisé Aletheia. Cet agent combine génération, vérification en langage naturel et itérations (révision/retry), et peut même « admettre l’échec » pour éviter de perdre du temps à s’entêter.

C’est un indice fort : Google ne vend pas seulement un modèle plus intelligent, mais une méthode de travail (générer → vérifier → corriger) qui colle aux exigences du raisonnement scientifique.

Le « premium » se déplace vers l’inférence

Avec Deep Think, Google pousse une logique de plus en plus visible dans l’IA grand public : la différenciation ne se joue pas uniquement sur « le modèle », mais sur le mode (raisonnement approfondi, plus coûteux) et sur l’intégration (API, workflows, agents). D’où l’accès réservé : Ultra d’un côté, « early access » de l’autre.

En creux, c’est aussi une annonce tournée vers les entreprises et la recherche : si Deep Think est réellement performant sur des tâches ambiguës et « sales », il devient moins un outil de démonstration qu’une brique de productivité — à condition d’avoir les garde-fous (traçabilité, validation, reproductibilité) que ces milieux exigent.